Als ich dann begann zu googeln fand ich die Infos dazu, dass 23.976 wohl für NTSC Kompabilität sind.

Wie ich weiter oben schon schrieb, ist NTSC genaugenommen auch nicht 60Hz, sondern eben 59,96Hz... Inwiefern das zur Frequenz des Stromnetzes passt, sei mal dahingestellt, aber die 0,04Hz Differenz sollten vernachlässigbar sein. Das lag aber an der anlogen TV-Ausstrahlung.

Kinofilme dagegen wurden von Filmrollen abgespielt und zwar mit ~24fps. Weil da Film abgewickelt wurde, glaube ich kaum das DAS was mit der Stromnetzfrequenz zu tun hatte.

Ob das da dann genaugenommen 23,976fps gewesen sein sollen, weiß ich nicht. Noch weniger warum das so gewesen sein sollte.

Ich meine nur weil hier von teilbarkeit durch 24 gesprochen wurde... ist eben relativ häufig kein integer sondern float value.

Imho hat das wenig bis gar nichts damit zu tun, warum man bei (PC-)Monitoren exakt 144Hz gewählt hat.

Die 144Hz stammen auch aus dem PC-Bereich, nicht aus dem Hifi-Bereich. Ich denke also nicht, das die 144Hz großartig was mit 23,976/24/25/29,96/30fps diverser Senderstandarts zu tun haben/hatten. Die kommen einfach daher, das 144Hz deutlich flexibler ist als 60Hz oder auch 120Hz, vorallem eben wenn man nicht von fixen Wiederholraten... bzw. FPS ausgehen kann.

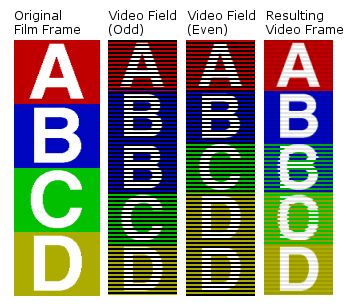

Im Hifi-Bereich waren über 60Hz auch lange eher 120Hz Standard. Damit konnte man eben 24fps und 60fps "ruckelfrei" wiedergeben. Und die 0,0x Abweichung zu 23,976 oder 29,96Hz hat man einfach ignoriert... die fällt halt auch kaum auf, schon gar nicht bei analoger Interlacewiedergabe.

In Europa deswegen nebenbei auch lange 100Hz statt 120Hz... weil halt basierend auf 50Hz PAL.

Kinofilme die mit 24fps aufgezeichnet wurden, wurden im PAL-TV oder auch auf PAL-DVD später häufig einfach mit 25fps abgespielt, die liefen also einfach nur ein bisschen schneller.

Funfact: SNES-Spiele liefen in der EU/PAL-Version einfach mit 25 statt knapp 30fps, also ~16% langsamer. Bei actionreichen Titeln wie z.B. Street Fighter merkte man das wenn man denn mal einen Vergleich hatte deutlich.

Bei den 144Hz war obendrein auch die Bandbreite zwischen Quelle und Monitor ein "Problem". Die war einfach beschränkt und deswegen konnte man nicht einfach 196, 240 oder sonstwas Hz nehmen. HDMI konnte bis vor Version 1.3 (2006) in FHD nur maximal 73fps (16Bit Farbtiefe) übertragen.

Allgemein ist da vieles ein Relikt aus der analogen Signalübertragung (nicht zuletzt das vermalledeite Interlaced, was diverse TV-Sender heute noch in 1080i senden). Ich hab mich ja Mitte der 2000er schon gefragt, warum die aufkommenden TFT-Monitore überhaupt eine fixe Wiederholrate haben, statt einfach das Bild anzuzeigen, wenn es halt kommt. Von der Anzeigetechnik her war das eigentlich nichtmehr nötig... aber man brauchte es halt trotzdem um TFT-Monitore an z.B. VGA-Anschlüssen betreiben zu können.

Wie ebenfalls schon gesagt: Mit sowieso derart hohen Frequenzen und noch dazu Techniken wie VRR... mittlerweile sowieso alles weitgehend obsolet.

Wenn man 25fps auf 60Hz abspielt, wirkt das durchaus störend. Auf einem 60Hz-Monitor sind 50fps ein Graus. Entweder man hat sichtbare Mikroruckler oder Tearing. Auf einem 144Hz Monitor dagegen fällt das kaum mehr auf, obwohl natürlich immernoch vorhanden. Das ist auch selbsterklärend: Wenn man bei 60Hz einen Framesync verpasst, hat man ein Standbild von 32ms ausserhalb der 16ms regulären Updates. Das merkt man durchaus. Auf einem 144Hz-Monitor hat man bei einem verpasstem Sync lediglich 14ms Standbild.... also sogar noch weniger als man bei einem 60Hz-Monitor ein reguläres Bild sehen würde.

www.eoshd.com

www.eoshd.com

Egal... BTT passt immer

Egal... BTT passt immer